字节跳动旗下Seed团队近日宣布,正式推出新一代音视频创作模型Seedance 1.5 pro。这款模型突破传统视频生成框架,首次实现音视频的深度协同创作,标志着AI内容生成技术进入视听融合的新阶段。

相较于前代1.0版本聚焦于运动稳定性的优化,Seedance 1.5 pro在技术架构上实现质的飞跃。该模型不仅支持从文本到音视频的完整生成链条,还能通过图像引导完成跨模态创作。通过引入多维度感官协同算法,模型成功将声音元素无缝融入视频生成过程,使角色口型、语调变化与画面动作保持高度同步。

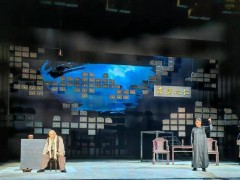

在技术突破方面,新模型展现出三大核心优势:其一,支持全球主流语言及特色方言的语音生成,能够精准捕捉不同语种的韵律特征与情感表达;其二,内置专业级运镜控制系统,可自主完成长镜头跟踪、希区柯克变焦等复杂拍摄手法,配合电影级调色方案显著提升画面张力;其三,通过增强语义解析能力,模型能自动构建符合叙事逻辑的场景衔接,为专业创作者提供智能化辅助工具。

独立评测数据显示,Seedance 1.5 pro在音画同步精度、动态表现力等关键指标上达到行业领先水平。特别是在多语言支持测试中,模型对不同方言的语音特征还原度超过92%,运镜复杂度指标较前代提升37%。这些技术突破使得AI生成内容在专业创作领域的应用成为可能。

目前,Seedance 1.5 pro已全面接入字节跳动旗下即梦AI和豆包平台。用户通过简单文本指令即可生成包含专业配音、动态镜头、电影级调色的完整视频作品,创作效率较传统方式提升数十倍。该模型的推出,正在重新定义数字内容创作的生产力标准。